Centos服务器部署deepseek-r1模型及远程调用

Hello Everybody,最近各路群里DeepSeek聊得热火朝天,爱倒腾的袁小威哪里闲得住。

今天,就给大家安排一下云端服务器本地部署DeepSeek并远程链接使用的教程,这是我亲自实验总结出来的教程,就算是小白也能够看得懂哦~

整体分三步走:

1.安装、配置Ollama 2.下载DeepSeek-R1模型 3.搭建Chatbox

一.安装、配置Ollama

这里有人会问了,Ollama是个啥?这里咱们可以理解成是运行模型的容器,而且开源、免费。

对于下载Ollama为了避免你们多走弯路,我直接替你们整理好了,只需要在服务器里执行即可(这里需要root权限才可以哦)

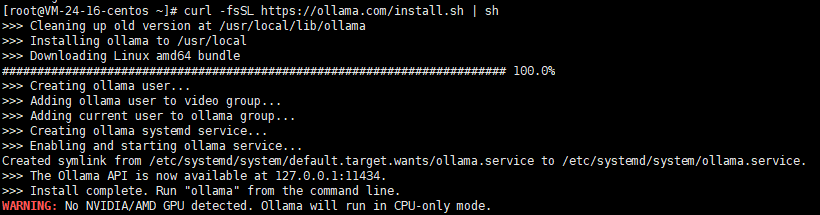

curl -fsSL https://ollama.com/install.sh | sh

GPU,所以这里最后会有个警告,可以不用管他,不会影响普通的个人使用。还有就是这里可能有些服务器无法正常请求github进行下载,所以此处需要自行解决这个问题哟

安装好Ollama后,咱们需要对他进行配置修改,以便可以外部任何地方都能够访问到它,这样我们云端部署完就可以随时随地能用啦~

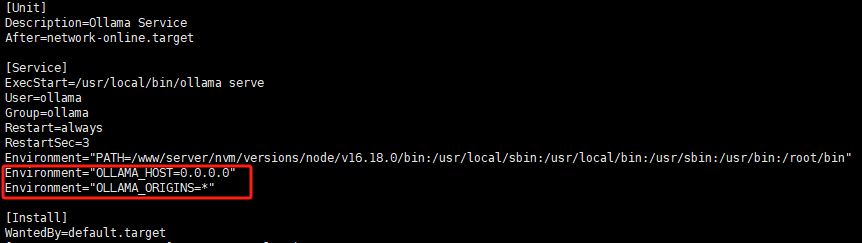

配置很简单,修改pllama.service配置文件

Vim /etc/systemd/system/ollama.service

在service部分下面增加两行参数

Environment="OLLAMA_HOST=0.0.0.0" Environment="OLLAMA_ORIGINS=*"

然后重启ollama服务即可

systemctl daemon-reload systemctl restart ollama

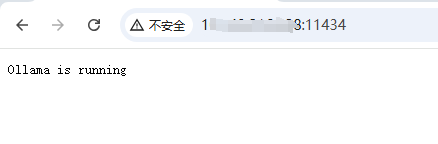

这样操作完以后,我们通过服务器Ip:11434端口(如:192.168.1.1:11434)外部访问ollama服务啦,当浏览器显示Ollama is running则表示第一步咱们顺利完成了,咋样,是不是so easy~

二.下载DeepSeek-R1

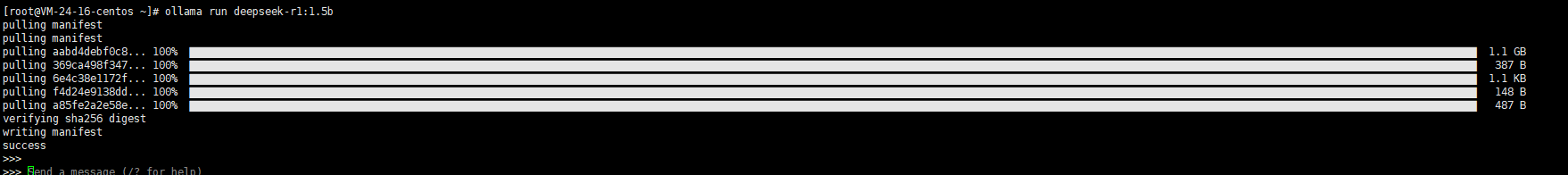

老规矩,小威已经整理好执行脚本,直接运行即可(也可以根据自己服务器配置高低,选择更大参数的模型)

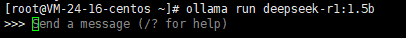

ollama run deepseek-r1:1.5b

第一次运行会先下载模型,首次成功之后再运行就是直接进入对话模式了~

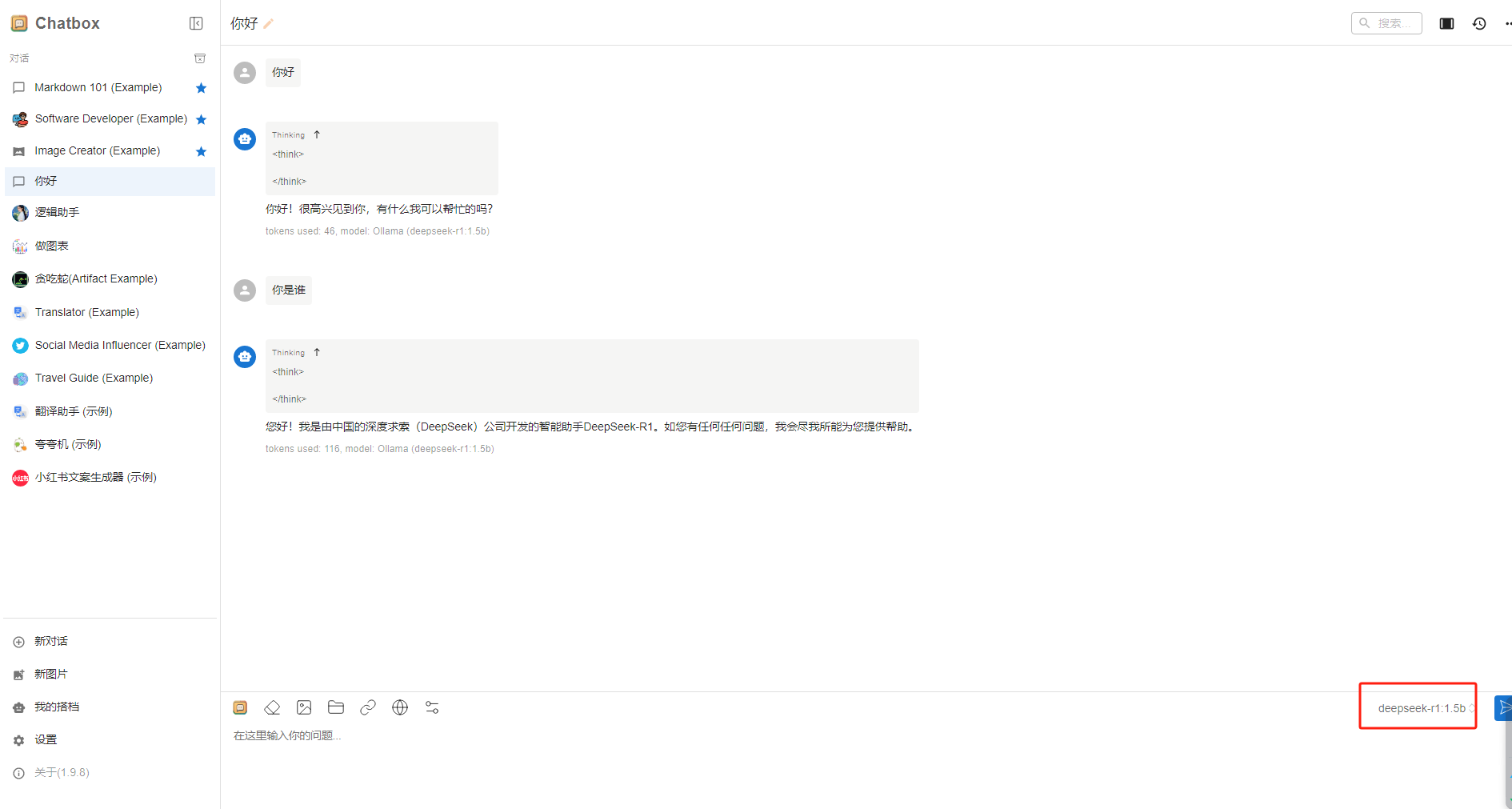

至此,我们基本上是可以正常使用DeepSeek了,如图:

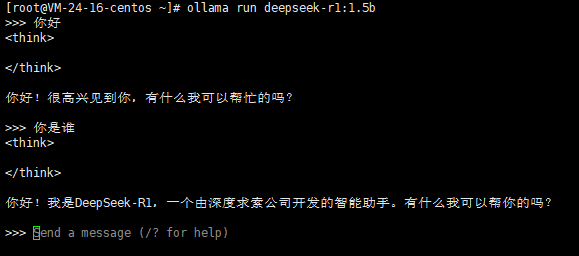

三.搭建Chatbox

以上两步基本已经完成了服务器端DeepSeek的部署,那为了方便我们在自己电脑上运行使用云端部署的DeepSeek,我们就需要安装Chatbox来可视化模型,下载安装也很简单,直接打开官网:https://chatboxai.app/zh,选择你设备对应的版本,下载安装就可以了(因为我是windows,所以它默认就是windows版本的):

安装完后,打开Chatbox进行配置(这里选择下面的,因为我们要用自己部署的模型):

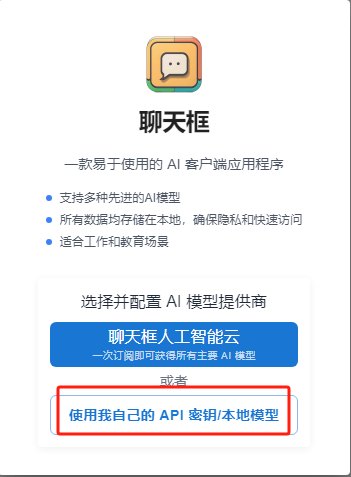

选择Ollama API:

API域名栏输入自己的服务器IP地址和端口号,以及选择安装的模型,然后点保存:

进行对话测试:

至此,简单三步,就在云端成功部署了一套自己专属的,并且在任何设备都能链接使用的DeepSeek啦~

写在最后,有些注意事项需要最后交代一二: 1.配置ollama的时候,设置的0.0.0.0是表示任何ip都可以访问你的服务器,这样服务器容易遭到攻击,所以建议最好设置固定的ip进行访问; 外部访问,服务器防火墙设置里要放行11434端口,否则也无法访问

好了,最后祝大家玩的开心~咱们下次再见~

很赞哦! (0)

赏

上一篇: 微信小程序之HTML富文本解析

下一篇: 已经是最后一篇了

一款超好用的插件——WxParse,在解析内容的时候就需要将内容中的HTML标签转换成微信小程序所支持……

一款超好用的插件——WxParse,在解析内容的时候就需要将内容中的HTML标签转换成微信小程序所支持…… 上次介绍了什么是公众号第三方平台,今天咱们讲具体如何操作来创建属于你自己的微信第三方平台。

上次介绍了什么是公众号第三方平台,今天咱们讲具体如何操作来创建属于你自己的微信第三方平台。 今天要讲的是代微信公众号接收消息并进行回复,这里要用到的就是咱们之前在微信公众号三方平台开发之帐号注册……

今天要讲的是代微信公众号接收消息并进行回复,这里要用到的就是咱们之前在微信公众号三方平台开发之帐号注册…… 在做微信小程序的过程中,总是会冒出那么些没接触过的功能,然后就开始各种踩坑,最近要做一个长按录音的功能……

在做微信小程序的过程中,总是会冒出那么些没接触过的功能,然后就开始各种踩坑,最近要做一个长按录音的功能…… 嘘~告诉一个灰常实用的垃圾分类技能~

嘘~告诉一个灰常实用的垃圾分类技能~ 使用TortoiseGit提交代码时报:RPC failed; HTTP 413 curl 22 Th……

使用TortoiseGit提交代码时报:RPC failed; HTTP 413 curl 22 Th……